加载中

加载中

表情图片

评为精选

鼓励

加载中...

文件下载

加载中...

理论我帮楼主补充吧。

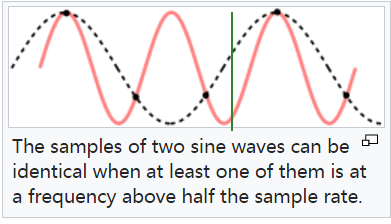

如果是常见的等间隔采样,根据nyquist定理,只有频率小于f/2的信号可以被完整还原。比如等间隔采样频率是1000Hz,我们就无法区分400Hz和600Hz信号,因为采样这两个信号时得到的结果是一样的。

不过,如果我们可以判断每次采样到的信号是处在上升还是下降段,就可以将400Hz和600Hz区分开了。要想知道某次采样到底是上升沿还是下降沿,只需在下一次采样时加一点offset。

如上图所示,只需在绿线处采样一次,就可以将两种频率区分开。如果可以在等间隔采样点周围大量采样,我们最终可以把400/600/1400/1600...等频率全部区分开。

经过研究,数学家们指出:把采样过程换成随机等效采样(即人为加入高斯jitter)之后,我们是可以正确区分比采样频率更高的信号的,代价是损失时域分辨率。可以认为:采样频率不变的情况下,时域分辨率越低,频域的分辨率就越高,反之亦然。整个过程仍然符合shannon,但突破了nyquist。

换言之,有了压缩感知理论以后,我们可以用时域分辨率换取超过nyquist频率的频域分辨率,比如用1G采样率的示波器,正确还原5G连续信号的幅度和相位。